Hadoop HDFS 源码解析记录

mikevictor 人气:0版权说明: 本文章版权归本人及博客园共同所有,转载请标明原文出处( https://www.cnblogs.com/mikevictor07/p/12047502.html ),以下内容为个人理解,仅供参考。

文本参考书籍《Hadoop2.x HDFS源码剖析》编写。

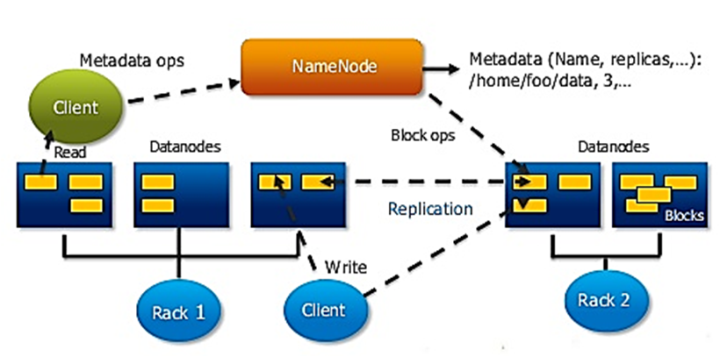

一、HDFS体系结构

1、数据块Block

最小存储单元,默认128MB,适合大文件存储,减少寻址和内存开销。

2、Namenode

文件系统命名空间,含目录、文件的数据块索引,索引存储在内存中,文件越多占用内存越大。

同时存储命名空间镜像文件(FsImage)与编辑日志文件(EditLog),文件的变更先写入日志文件中。

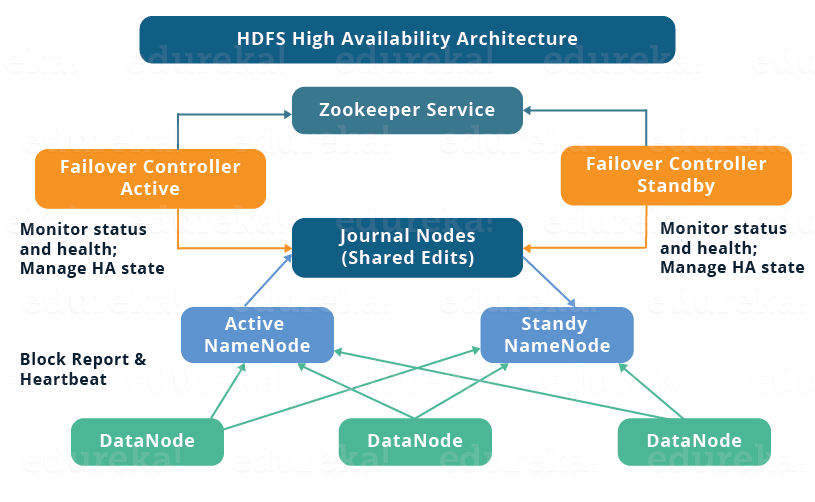

2.X版本引入HA功能,通常通过Journal Nodes保持多主间EditLog同步。再加入ZKfailoverController进行主备切换操作(也可人工切换)。

3、Datanode

数据存储节点,执行数据块的创建、删除、复制等操作。

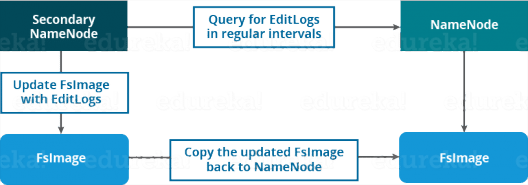

4、Secondary Namenode

由于Namenode 合并EditLog和FsImage非常耗时,特别在大型集群中。故增加一个secondary namenode负责定时从namenode获取(HTTP)EditLog并且合并到FsImage中,耗时的合并工作完成后将新的FsImage传回namenode。

二、HDFS主要流程

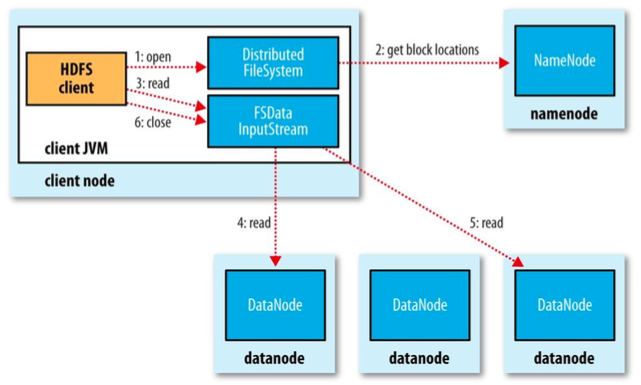

2.1 客户端的读取

1、调用DistributedFileSystem.open打开文件(底层调用DFSClient.open)并创建HdfsDataInputStream。

2、通过调用DFSClient.getBlockLocations获取数据块所在的datanode节点列表,根据排序规则选择一个datanode建立连接获取数据块,当此数据块读取完毕后,再次向namenode获取下一个数据块。依次循环。

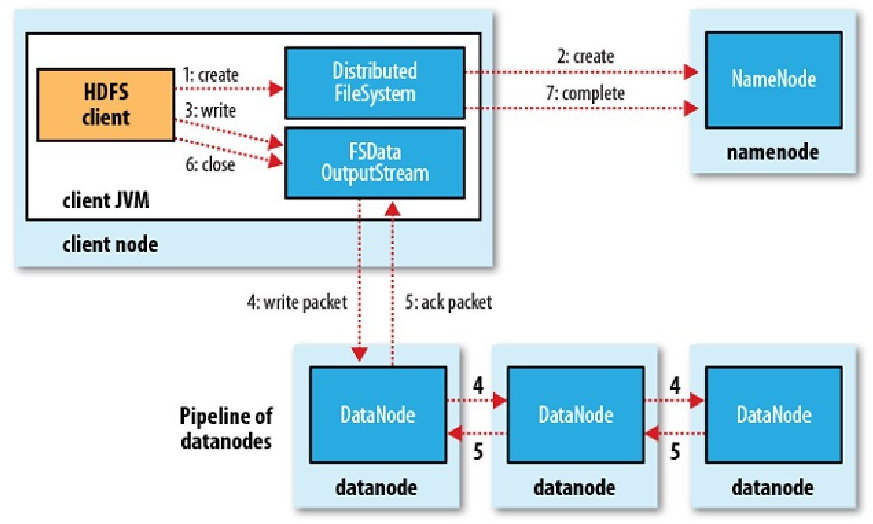

2.2 客户端写入流程

1、通过调用DistributedFileSystem.create在底层调用DFSClient.create发送通知namenode创建文件。

2、获取输出流后就可以调用DFSOutputStream写数据,空文件时就会调用Clientprotocol.addBlock向Namenode申请一个数据块并返回LocatedBlock,此对象包含该数据块的所有节点信息,后续即可往其中一节点write数据。

2.3 HA切换流程

Hadoop 2.X之前版本NN存在单点故障,HA功能提供一个active NN与一个standby NN,命名空间实时同步。Active NN修改命名空间时同时通知多数的Quorum Journal Nodes(JNS),standby NN监听JNS中的editlog变化,并与自身的命名空间合并,当发生切换时,需要等待standby合并JNS上的所有editlog后才会进行切换。

ZKFailoverController会实时监控NN的状态,如果active NN处于不可用状态则进行自动主备切换,不需要人工干预,当然管理员也可用DFSHAAdmin命令进行手工切换。

三、NameNode

3.1 文件目录树

HDFS命名空间在内存中以树结构存储,目录与文件抽象为INode节点,目录为INodeDirectory,文件为INodeFile。目录有List<INode> children存储子目录或文件(内部使用二分法做检索),HDFS命名空间存储在本地系统FsImage文件中,启动时加载,与此同时NN会定期合并fsimage与editlog,editlog操作类为FSEditLog。

INodeFile主要成员变量:

private long header = 0L; # 文件头信息

private BlockInfoContiguous[] blocks; # 数据块与数据节点关系

3.2 数据块管理

1、NameNode启动时从fsimage加载文件与数据块之前的关系,数据块存储在哪些节点上具体是由datanode启动时向NN上报数据块信息时才能构建。

2、BlockMap在NN中存储数据块与节点的关系,该关系则由DN上报时更新。

3.3 数据节点管理

1、添加和撤销DN:HDFS提供的dfs.hosts可配置include和exclude,如果节点下线则配置exclude并执行dfsadmin -refreshNodes后NN开始进行撤销,下线的节点数据会复制到其他节点上,此时DN则处于正在被撤销状态,复制完毕后DN状态则变成已撤销。

2、DN启动需要向NN握手、注册于上报数据块,并定期发送心跳包。

3.4 NN的启动与停止

1、NN启动由NameNode类的main方法执行,并调用createNameNode方法进行初始化。调用FSNamesystem.loadFromDisk进行fsimage与editlog。

2、NN的停止则是通过启动时注册JVM的ShutdownHook,当JVM退出时调用,并输出一些退出日志。

四、数据节点DN

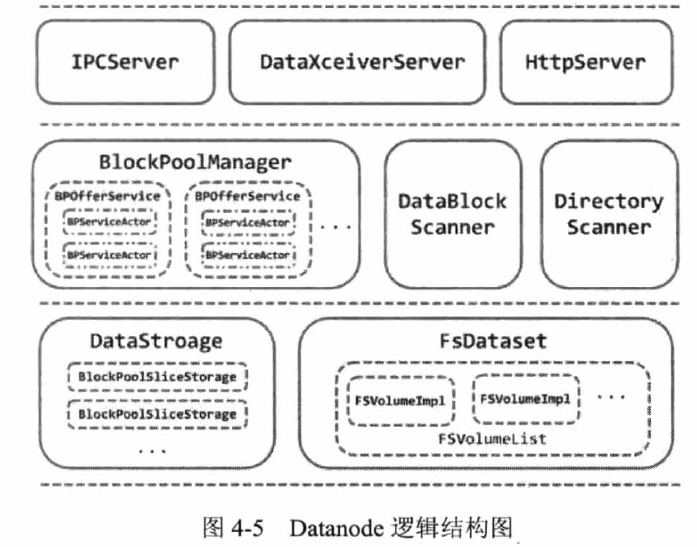

HDFS 2.X DN使用Federation架构,可配置多个命名空间,每个命名空间在DN中对应一个池。DN的启动由DataNode类的main方法执行,关闭也是注册了JVM的钩子。

1、DataBlockScanner扫描数据块并检查校检和是否匹配。

2、DirectoryScanner定时扫描内存元数据与磁盘是否有差异,如有则更新内存。

3、IPCServer为RPC服务端,接收Client、NN、DN的RPC请求。

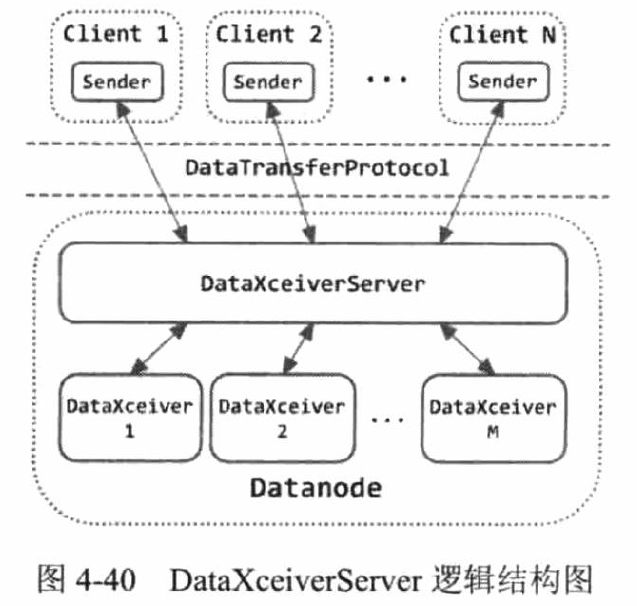

4、DataXceiverServer用于流式数据传输。

4.1 DN磁盘存储与读写

1、DFSStorage管理数据块,管理磁盘存储目录(dfs.data.dir),dfs.data.dir可定义多个存储目录,不同目录磁盘克异构。

2、DataTransferProtocol定义了基于TCP流的数据访问接口,包含Sender和Receiver,流程如下图:

五、HDFS常用工具

1、FsShell : bin/hadoop fs <args>

2、DFSAdmin: bin/hdfs dfsadmin <args>

加载全部内容