python人工智能BackPropagation链式法则 python深度学习人工智能BackPropagation链式法则

Swayzzu 人气:01.链式法则

根据以前的知识,如果我们需要寻找到目标参数的值的话,我们需要先给定一个初值,然后通过梯度下降,不断对其更新,直到最终的损失值最小即可。而其中最关键的一环,就是梯度下降的时候,需要的梯度,也就是需要求最终的损失函数对参数的导数。

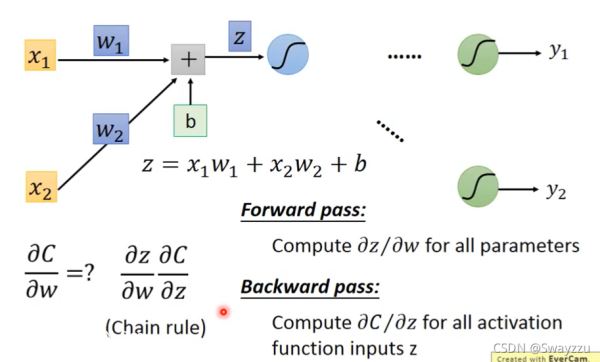

如下图,假设有一个神经元,是输入层,有2个数据,参数分别是w1和w2,偏置项为b,那么我们需要把这些参数组合成一个函数z,然后将其输入到sigmoid函数中,便可得到该神经元的输出结果。过程中,z对w求导十分好算,就是x1和x2。根据链式法则,如下图左下角所示,我们整体的计算过程就是,通过前向传播求出z对w的偏导,再通过反向传播找到损失函数C对z的偏导。

2.前向传播

计算z对w的偏导:前向传播相当简单,对参数的偏导结果就是参数对应的输入数据,如下图所示。输入数据对于输入层来说就是原始数据1和-1,对于其他层,输入数据就是通过sigmoid转换后的输出结果。

3.后向传播

计算C对z的偏导:

设每一个神经元中,sigmoid函数最终的输出为a,则C对z的偏导,根据链式法则,就可以写作a对z的偏导,乘上C对a的偏导。

a对z的偏导,只是一个sigmoid函数,该函数偏导可以计算。

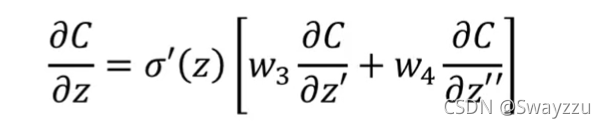

C对a的偏导,由于a输入进了下一层的多个神经元,假设有2个,因此,C对a的偏导,等于分别对这两个神经元求偏导并求和。比如第一个神经元z' = 输入a*权重w3+...,那么C对这个神经元求偏导,就是C对z'求偏导,乘上z'对a求偏导,后一项十分简单,就是w3;对于z''来说,对a求偏导就是w4

那么问题又变成了,C对z', z''求偏导的结果是什么?

假!如! 损失函数C对z'和z''的偏导已知了:

以上C对z求偏导的计算过程,可以写作以下的式子,括号外就是a对z求偏导,括号内就是C对a求偏导:

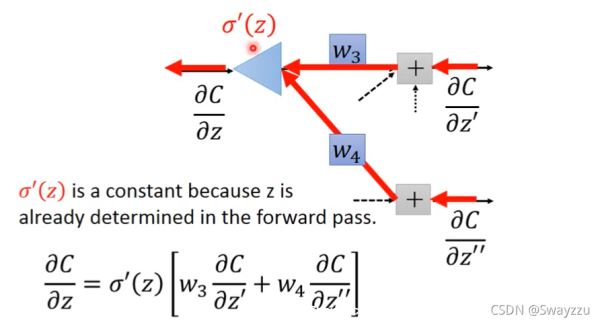

这个式子可以看做一个反向传播的神经元,如下图所示:

这个神经元中,损失函数C对sigmoid转化前的z' 和z''求导的结果,就是输入,权重w3,w4是输入对应的权重,将这两个输入乘上参数后相加,再和sigmoid函数对z的导数相乘,最终得到C对z的偏导。而sigmoid对z的导数,这个是常数,并且已经是确定了的,因为我们通过前向传播计算,就已经能够将其确定。

有了第一个反向传播的输出结果,那么就可以有隐藏层的其他神经元所需要的结果,以此类推,对于所有神经元,我们均可算出损失函数对其z的偏导。有了这个,那么我们结合z对w的偏导,就可以计算出每一个参数w的梯度。从而进行梯度下降。

4.计算方式整理

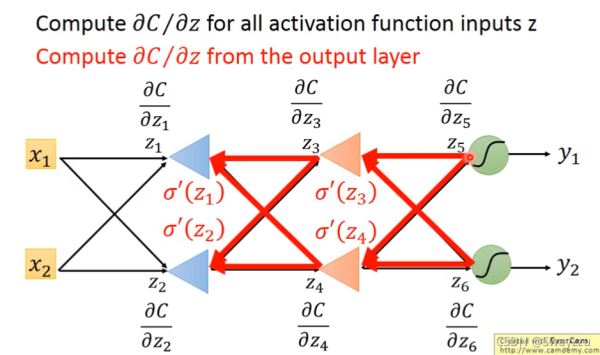

假设我们计算的是输出层,那么我们通过前向传播后,已经得到了一个输出了,于是就已经有损失函数C了,同时前向传播也让我们得到了z'和z'',那么所有需要的数据已就绪,可以直接计算出来C对z'和z''的偏导。

假如我们计算的是中间层,在计算C对z'的偏导的时候,还需要下一层通过反向传播给到的C对两个其他z的结果,那么我们就继续往下计算,继续寻找下一层计算的时候,需要的下下一层的信息,一直到输出层后,我们得到一个,再往回推,以此递归计算前面待定的所有项。

5.总结

既然我们需要输出层的内容作为反向传播的输入,我们在进行完前向传播之后,就别考虑前面需要什么求导了,干脆直接从结尾开始算起,得到每一层的损失函数C对每一个z的偏导即可。

至此,我们得到了每一个神经元前向传播的z对w的偏导(其实就是sigmoid转化后的输出a),以及每一个神经元反向传播后的C对z的偏导,二者相乘,就得到了我们需要的结果,也就是每一个参数的梯度。

加载全部内容